17

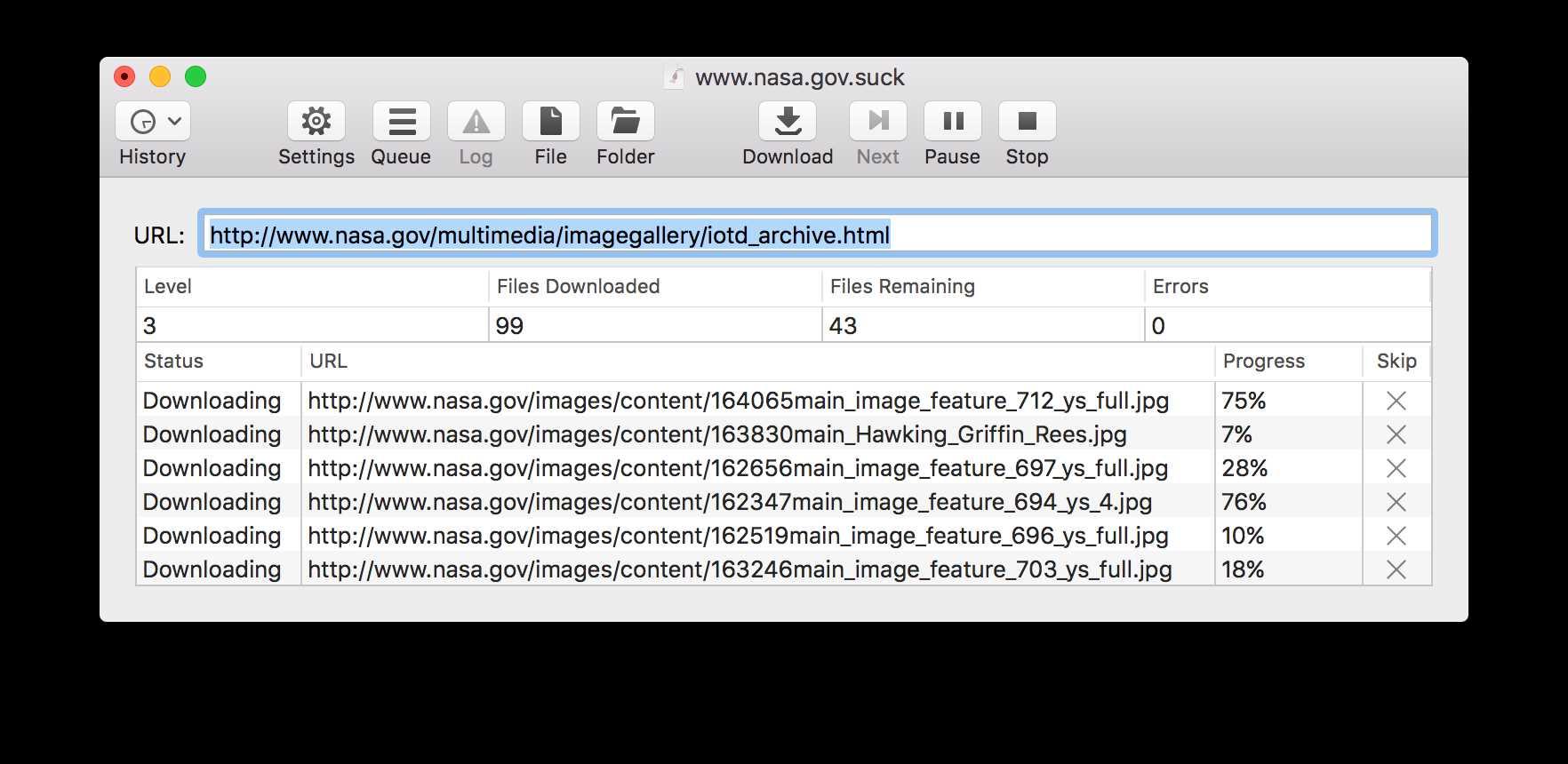

SiteSucker是Macintosh应用程序,可以从Internet自动下载网站。它通过将站点的网页,图像,PDF,样式表和其他文件异步复制到本地硬盘驱动器,从而复制站点的目录结构来实现此目的。只需输入一个URL(统一资源定位符),按回车键,SiteSucker就可以下载整个网站。SiteSucker可用于制作网站的本地副本。默认情况下,SiteSucker将下载的文件“本地化”,使您可以脱机浏览站点,但是它也可以下载站点而无需修改。

分类目录

Mac版SiteSucker的替代品

85

34

14

PageArchiver

PageArchiver(以前称为“ SingleFile剪贴簿”)是一个Chrome扩展程序,可帮助您存档网页以供离线阅读。主要功能包括:

14

7

WebScrapBook

浏览器扩展程序,可高度自定义地忠实捕获网页。

3

2

Offline Pages Pro

Offline Pages Pro可能是世界上最先进的离线浏览器。下载具有所有格式,文档,视频和客户端交互性的整个网站,以便您可以脱机浏览-无需任何Internet连接。

1